Teilprojekt 3: Optische Unterwasser 3D-Messtechnik

Des Projekts Entwicklung innovativer Technologien für autonome maritime Systeme (EITAMS)| Teilprojektleiter | Prof. Dr.-Ing. habil. Thomas Luhmann |

| Teilprojektmitarbeiter | Robin Rofallski M.Sc. |

| Teilprojektvolumen | 241.727 € |

| Fördermittelgeber | Nds. Ministerium für Wissenschaft und Kultur - VW-Vorab/Wissenschaft für nachhaltige Entwicklung |

| Teilprojektlaufzeit | 01/2017 bis 03/2020 |

Der Meeresgrund besteht aus einer Vielzahl geometrisch erfassbarer Strukturen. Diese umfassen neben menschengemachten Objekten, wie etwa Offshore-Windparks oder Schiffswracks, auch eine Vielfalt natürlicher Phänomene und Lebewesen, wie Korallen, vulkanische Strukturen und viele mehr. Die vollständige, genaue und möglichst automatisierte dreidimensionale Erfassung dieser unterseeischen Objekte hat für viele Fachdisziplinen, wie der Meeresbiologie, Geologie oder der Bau- und Materialwissenschaft, einen hohen Mehrwert.

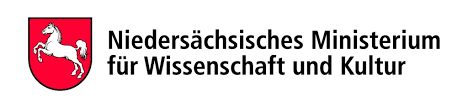

Das Teilprojekt Optische Unterwasser 3D-Messtechnik widmet sich dieser Aufgabenstellung und erarbeitet neuartige Verfahren im Bereich der Photogrammetrie. Hierbei werden räumliche Informationen, wie etwa 3D-Punktwolken aus einem oder mehreren Bildern, mit Submillimetergenauigkeit abgeleitet. Die hochgenauen Punktwolken können jedoch nur durch bekannte Passpunkte oder zusätzliche Sensorik in ein übergeordnetes Koordinatensystem überführt werden. Grundlage hierfür ist das Lochkameramodell, welches einen gradlinigen Verlauf des Lichts von einem Punkt durch das Projektionszentrum der Kamera auf den Sensor voraussetzt. Aufgrund der unterschiedlichen Brechungseigenschaften von Wasser und Luft kann dieses Modell unter Wasser so jedoch nicht verwendet werden und muss daher angepasst werden (siehe Abb. 1).

Ziel ist es, eine Trägerplattform (bspw. der BlueROV 2 von der Firma Blue Robotics) mit einem Stereokamerasystem auszustatten und mit dessen Hilfe eine Aufnahme von unterseeischen Objekten durchzuführen. Die Kameras sind hochpräzise Industriekameras, die mechanische Stabilität und zugleich hohe Bildwiederholungsraten bei hoher Auflösung gewährleisten.

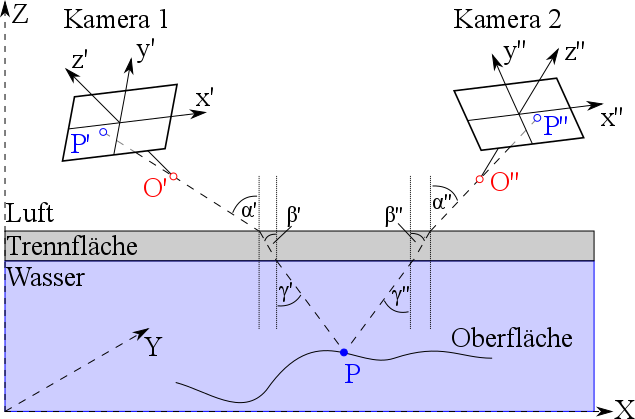

Neben der Entwicklung von Kalibrierverfahren, welche sowohl vor der Mission als auch in-situ durchgeführt werden, wird die Fusion mit weiterer Sensorik, wie einem USBL-Receiver in Kombination mit einem Akustik-Modem und GNSS-Empfänger, sowie der ROV-inhärenten Inertialmesseinheit (IMU) angestrebt. Diese sollen den Bezug zu einem übergeordneten Koordinatensystem einer photogrammetrischen Lösung herstellen und zugleich die hohe Relativgenauigkeit bewahren. Mithilfe des Simultaneous Localization and Mapping (SLAM), einem Verfahren der Robotik, werden die Daten aller Sensoren in einem Prozess verarbeitet und die Eigenposition sowie eine dreidimensionale Erfassung der Umgebung ermittelt. Die so erhobenen Daten sollen während der Missionslaufzeit ausgewertet und mit einer normierten Schnittstelle an ein Datenmanagementsystem (TP 4) weitergegeben werden. Damit stehen die Daten auch zur Unterstützung der Navigation (TP 1) zur Verfügung. Nach der Mission sollen sämtliche Daten in einer Bündelausgleichung verarbeitet werden, um so nach der Methode der kleinsten Quadrate eine statistisch optimale Lösung des Bildverbandes zu generieren.